2024년 5월 13일에 GPT-4o(지피티-포-옴니)가 발표되었습니다.

유료로 사용하던 GPT-4 보다 더 나은 성능을 무료로 배포한다고 해서 큰 이슈가 되었죠.

운이 좋은 사람부터 차례차례 적용이 되더니 이제는 모두에게 적용된 듯 합니다.

엄청나다는 GPT-4o 기능. 제대로 활용하고 계신가요?

오늘은 GPT-4o에 대해 알아보고,

이 추세대로 가면 세상이 어떻게 바뀔지 생각해 보려고 합니다.

GPT-4o의 기능과 성능

1.

텍스트 처리 성능 : GPT-3.5 보다 말을 훨씬 잘 한다. 유료인 GPT-4를 이길 정도.

2.

처리 속도 : 말이 빠르다. 이제 GPT-4처럼 답답할 일은 없다.

3.

비용 : 전세계 무료 배포(사용량 제한은 있음), API 비용도 저렴

4.

멀티 모달 : 텍스트, 음성, 이미지를 하나의 모델이 입력을 받고 출력을 생성한다

5.

최근 데이터 학습 (Knowledge cut-off) : GPT-3.5 보다 최근 데이터 학습을 더 함

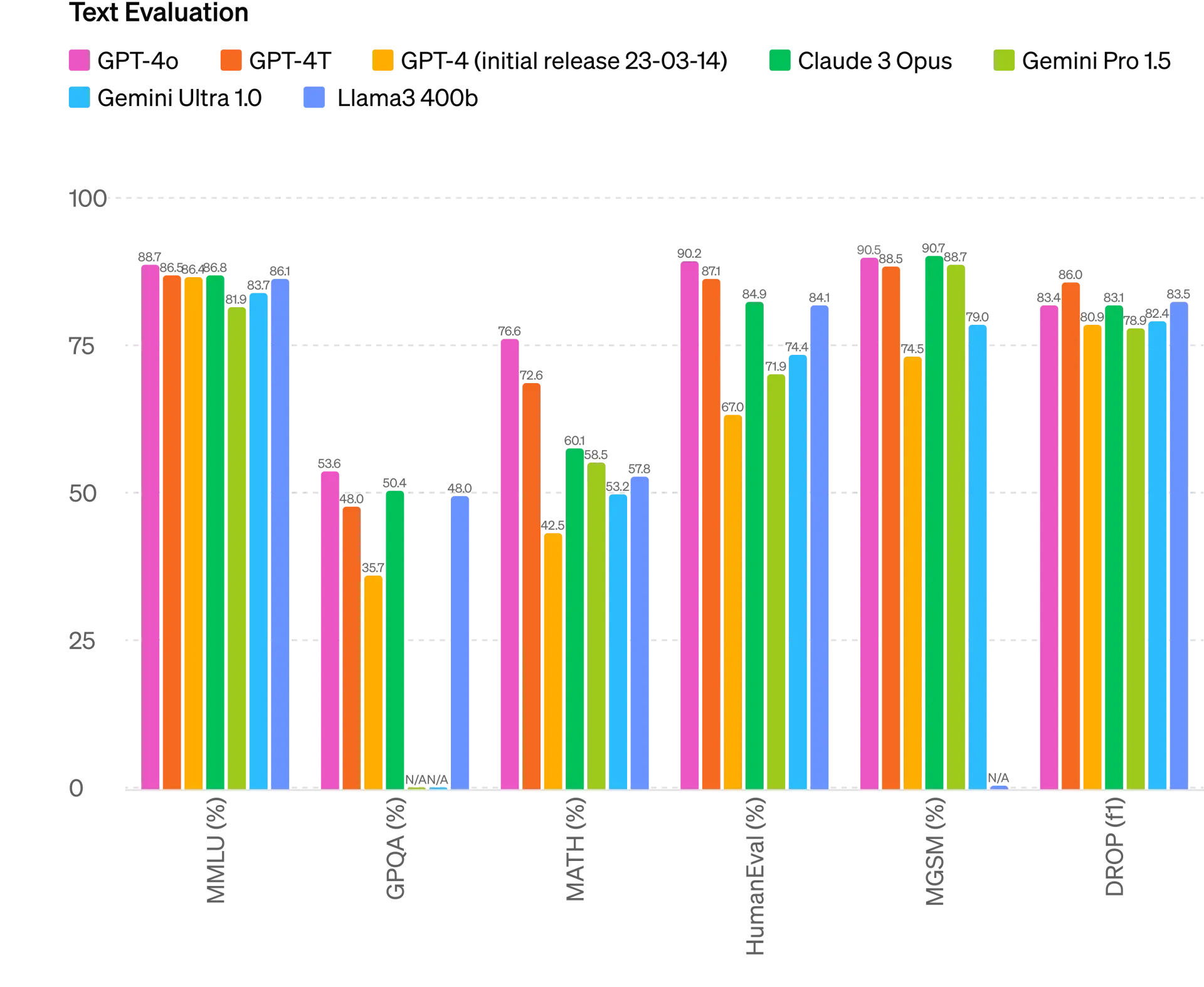

[1] GPT-4o의 텍스트 처리 성능

GPT-4o는 GPT-4 보다 글을 더 잘 씁니다.

GPT-4o가 출시되었지만, GPT plus(유료) 구독자는 여전히 GPT-4를 사용할 수 있습니다.

그런데 아래 텍스트 성능 평가를 보시면 GPT-4o가 GPT-4에게 지지 않는, 오히려 여러 항목에서 이기는 결과를 보여주고 있습니다.

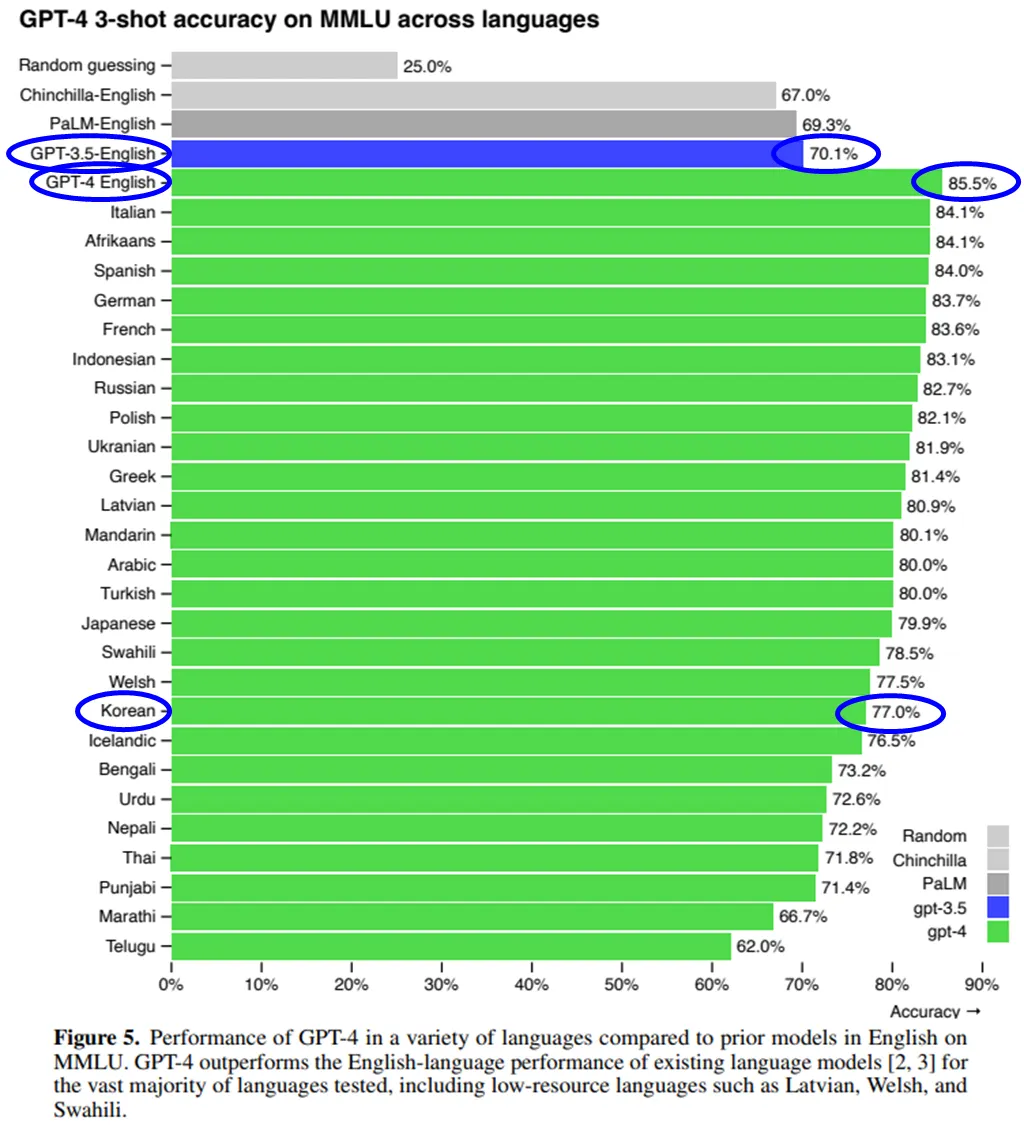

GPT-4o가 나오기 전에 무료로 사용하던 GPT-3.5와 GPT-4의 성능 차이는 아래와 같습니다.

GPT-3.5 한글 : unknown

GPT-3.5 영어 : 70.1%

GPT-4 한글 : 77%

GPT-4 영어 : 85.5%

무료인 GPT-3.5와 유료인 GPT-4는 이렇게나 큰 차이가 납니다.

한글보다 영어가 훨씬 능숙하다고 잘 알려져있는데,

GPT-4 한글이 GPT-3.5 영어보다도 더 뛰어난 그 정도의 차이입니다.

그런데 이제 이 GPT-4에게 지지 않는 GPT-4o가 무료로 배포가 되었네요.

전 지구인의 툴 상향평준화가 일어나네요.

GPT-3.5를 무료로 전세계인이 사용한다는 면에서 이미 업무 도구의 상향평준화였는데,

GPT 모델이 하나씩 풀릴 때마다(특히 무료로 풀릴 때) 엄청난 상상상향평준화가 일어나네요.

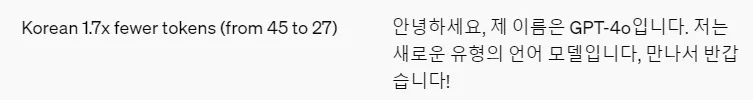

GPT-4o는 GPT-4에 비해서 특히 영어 이외의 언어에 강해졌습니다

GPT가 영어는 잘 하고, 다른 언어에는 약한 이유 중 하나는 토큰입니다.

한국어를 포함한 기타 언어는 토큰화 하는 과정이 비효율적이어서

같은 단어를 처리하는데 더 많은 토큰을 썼습니다.

그래서 생성도 느리고, 생성된 문장의 퀄리티도 낮아지고,

API를 쓸 경우에는 토큰 비용도 더 많이 나왔습니다.

하지만 GPT-4o가 이 부분을 또 해결했네요. 한국어를 처리할 때의 토큰 사용량이 많이 줄었습니다.

그만큼 더 정확한 표현, 더 빠른 응답, 더 낮은 API 비용이 가능해졌습니다.

한국어 뿐만 아니라 다른 여러 언어에서 아래와 같이 토큰 축소를 했습니다.

Gujarati 4.4x, Telugu 3.5x, Tamil 3.3x, Marathi 2.9x, Hindi 2.9x, Urdu 2.5x, Arabic 2.0x, Persian 1.9x, Russian 1.7x, Korean 1.7x, Vietnamese 1.5x, Chinese 1.4x, Japanese 1.4x, Turkish 1.3x, Italian 1.2x, German 1.2x, Spanish 1.1x, Portuguese 1.1x, French 1.1x, English 1.1x

[2] GPT-4o의 처리 속도

GPT-4o는 처리속도가 GPT-4 대비해서 2배가 되었습니다.

저는 당연히 유료 구독자이지만 그래도 평소에 GPT-4를 사용하지는 않았습니다.

GPT-3.5로 글 쓰고 리뷰하고 수정 지시하고 하면서 열심히 다듬다가,

나의 질문 프롬프트가 충분히 완성되었다 싶으면 그 때 GPT-4를 켜서 일을 시켰습니다.

바로 GPT-4가 너무 느렸기 때문입니다.

GPT-4o는 처리속도가 GPT-4 대비해서 2배가 되었습니다.

이제 GPT-3.5를 사용할 때와 거의 차이가 없다고 느껴집니다.

GPT-4o의 음성 대화 응답 속도는 진짜 사람과 같아졌습니다

GPT-4o는 오디오 input에 대해서 232 밀리초의 응답이 가능하고,

평균 320 밀리초의 응답을 합니다.

그리고 이것은 사람끼리의 대화 응답 속도와 비슷하다고 합니다.

저는 GPT-4와의 음성 대화는 운전할 때만 썼습니다.

PC에서 일 할때는 GPT-4의 느린 응답을 기다리기가 힘들어서 그냥 text로 대화를 했죠.

운전할 때는 text가 불가능하니 어쩔 수 없이 느리더라도 음성으로 대화한거죠.

그런데 이제 음성 대화가 빨라졌으니 운전할 때도 충분히 대화 상대가 되어 줄 수 있고

심지어 PC에서 일할 때도 text 보다 음성을 선호하는 날이 올 수 있겠어요.

우리의 일하는 풍경도 많이 달라지겠네요.

예를 들면 더 많은 사람에게 1인실 사무공간이 필요하겠지요.

마음껏 대화를 할 수 있어야 하니까요.

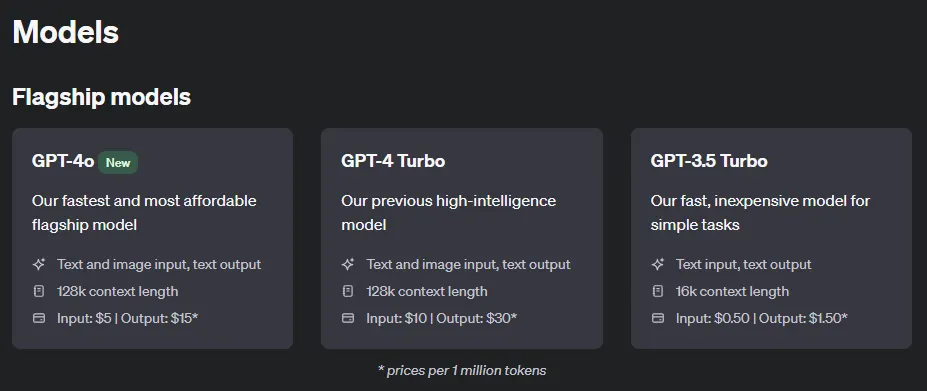

[3] GPT-4o의 비용

GPT-4o는 모든 사용자에게 무료입니다

이게 왜 전세계 무료 배포일까 의문입니다.

GPT-4가 유료(GPT plus 구독 필요)인데, 그에 지지 않는 GPT-4o가 무료라니요.

일단 써보기 시작하면, 성능이 강력하니 당연히 자주 쓰게 될 것이고,

그러면 당연히 유료 결제까지 하게 될 것이라는 작전 아닐까요.

단순한 작전이 아니라 엄청난 데이터 분석의 결론이겠지요.

GPT-4o는 GPT-4-turbo 대비 API 비용이 반값입니다

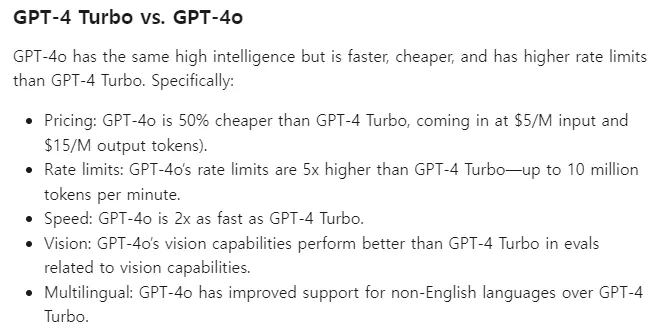

오픈AI 공홈에서 설명한 모델 설명입니다.

텍스트, 이미지 다 처리되는 것은 GPT-4 터보와 동일하고,

입력 프롬프트의 길이인 context window도 128k로 동일한데,

가격은 input도 output도 반값이 되었습니다.

Pricing: GPT-4o is 50% cheaper than GPT-4 Turbo, coming in at $5/M input and $15/M output tokens).

이러다가 GPT-4는 그냥 없어질 것 같네요…

GPT-4o는 GPT-4-trubo 대비 API 사용량 한도가 더 높습니다

GPT-4o는 API로 사용 시 rate limit이 1분당 1천만 토큰입니다.

[4] GPT-4o의 멀티 모달

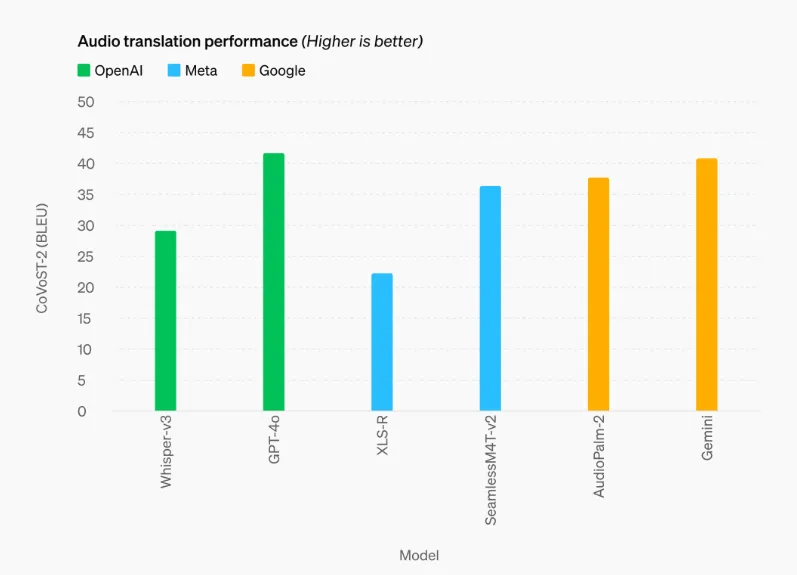

텍스트 처리 성능에 더해서, 음성 번역 성능까지 잡았습니다.

Whisper-v3는 오픈AI가 만든 STT(Speech-to-Text), TTS(Text-to-Speech) 담당하는 모델인데요,

그 음성 전용 모델보다도 더 뛰어난 오디오 번역 성능을 보여줬습니다.

이제 더 많은 언어를 더 정확하게 번역을 하게 된거죠.

Whisper와 같은 별도의 모델을 쓰는게 아니라, GPT-4o 안에 내장된 기능만으로도 말이죠.

비전(이미지) 처리마저 GPT-4를 이겨버렸네요.

여러가지 언어로 되어있고, 그래프나 표를 포함하는 시험을 치른 점수입니다.

모든 언어에서 GPT-4를 이겨버렸네요.

GPT-4는 유료인데도 불구하고 말입니다.

[5] 최근 데이터 학습 (Knowledge cut-off)

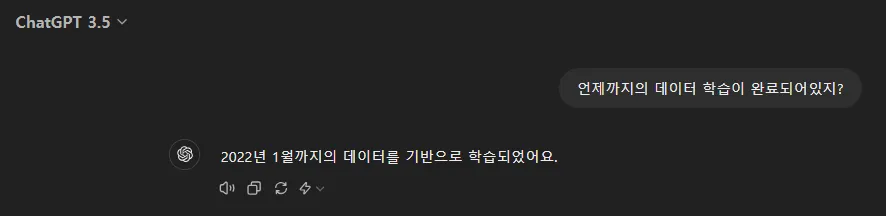

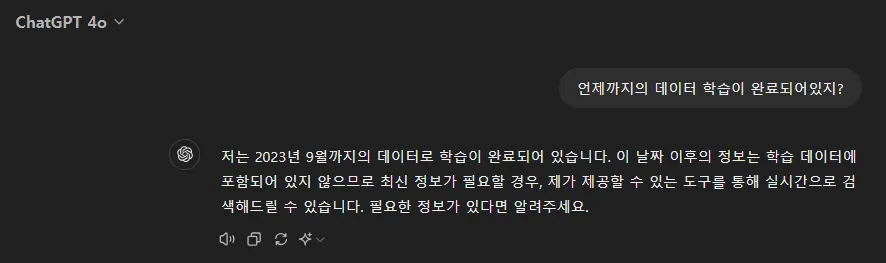

GPT-4o는 2023년 9월 데이터까지 학습을 완료했습니다.

무료로 사용하던 GPT-3.5는 2022년 1월 데이터까지 학습이 완료되어있었죠.

최초 출시했던 모델은 2021년 9월이었지만,

2023년 11월 7일에 있었던 Dev-Day 업데이트에서 큰 인심쓰면서 업데이트 해준 것이 2022년 1월까지였습니다.

GPT-4o는 2023년 9월 데이터까지 학습을 완료했습니다.

이미 여기에서 상당한 차이가 납니다.

더 최근 데이터까지 사전학습된 풍부한 배경지식을 바탕으로, 더 정교한 텍스트 처리 성능이 작동을 하니, GPT-3.5와는 상당한 글 품질 차이를 보여주게 되버렸습니다.

이제 GPT-4o를 겪어본 사용자들은 아마 GPT-3.5로는 못 돌아갈겁니다.

이걸 노리고 무료로 배포를 했겠지요. usage cap을 타이트하게 적용해서 말이죠.

무료 사용자에게 GPT-4o 외에 추가로 제공된 기능들

GPTs를 탐색하고 사용할 수 있습니다

GPTs를 찾아보는 Explore GPT 메뉴가 생겼습니다.

다른 사람이 만든 GPTs를 찾아보고 선택해서 대화를 나눌 수 있습니다.

하지만 GPTs를 만들지는 못합니다. 그건 유료 GPT plus에 포함된 기능입니다.

GPTs와 대화하는 횟수는 GPT-4o 사용량으로 집계됩니다. rate limit에 걸리면 대화가 막힙니다.

하지만 GPTs 중에서도 이미지 생성하는 건 안됩니다

무료 사용자에게 GPT-4o가 제공되었지만, 거기서도 이미지 생성은 안 되듯이,

GPTs로도 이미지 생성은 안 되게 막혀있습니다.

대화창에서 파일을 업로드 할 수 있습니다

이미지는 GPT-4o가 인식을 하고, 다른 파일은 파이썬 코드를 실행해서 내용을 파악합니다.

GPT-3.5 메뉴에서는 파일 업로드 버튼이 없었죠.

파일을 업로드 해야만 할 수 있는 수많은 작업들이 가능해졌습니다.

#별첨. GPT-4o의 몇가지 단점

GPT-4o는 사용량에 제한(rate limit)이 있습니다

3시간 누적으로 사용 횟수를 카운트 하고, rate limit이 넘치게 되면 대화는 중단됩니다.

GPT-3.5로 전환해서 대화를 이어가거나, GPT plus 요금제 구독을 해야 합니다.

그리고 이 한도는 GPTs 사용에도 적용됩니다.

GPT-4o 사용한도가 끝난 상태에서는 GPTs와 대화하는 것도 막힙니다.

유료 사용자(GPT Plus 요금제)는 GPT-4, GPT-4o를 더 많이 사용할 수 있습니다

GPT Plus 사용자는 GPT-4를 3시간마다 40회 대화, GPT-4o를 3시간마다 80회 대화 할 수 있습니다.

GPT Plus 보다 비싼 GPT Team 요금제를 사용한다면 이 usage cap은 더 높습니다.

이미지는 못 그립니다.

상당히 많은 기능을 풀어줬지만, 이미지 생성AI 달리를 사용할 권한까지는 안 주네요.

이미지 파일을 업로드하여 인식시키고 대화를 할 수는 있지만, 그림을 그릴 수는 없습니다.

GPT-4o를 통해 전망해 보는 미래

인간의 감각(시각, 청각)을 보완 또는 대체해서 신체 한계를 극복합니다

이미지를 처리하는 성능이 높아지고, 이를 audio로 빠르게 말해 줄 수 있으니

시각이 약한 분들을 위해 앞 길을 안내해 주고 상황을 설명해 줄 수 있습니다.

청각이 약한 분들을 위해 소리와 음성으로 주변 상황을 판단해서 text와 진동으로 안내할 수도 있구요.

그리고 이런 기술이 수천만원이 아니라 월 몇 만원의 구독료라는 것은 정말 좋은 소식입니다.

로봇의 퍼포먼스에 엄청난 발전이 옵니다

샤오미는 240만원 짜리 로봇 개를 발표했습니다.

사족보행으로, 걷고 뛰는 것은 물론 인사와 하이파이브, 점프, 문워크, 그리고 공중 덤블링까지 가능합니다.

인공지능(AI) 기능도 있어서 사람과 간단한 대화도 가능하다고 합니다.

이 정도 동작을 구현하기 위해 카메라 4대와 레이저 센서를 탑재했습니다.

여기에 GPT-4o가 더해지면 어떻게 될까요?

카메라 한 대로 주변 상황을 다 파악하고, 인간과 아주 자유로운 대화도 가능하고,

스스로 판단하고 결정하고 움직이겠지요.

영화 Her에서 봤던 인간 - 음성대화 전용 AI 사이의 정서적 유대관계는,

이제 SW only를 넘어 ‘로봇 반려견’이라는 HW까지 더해져서 인간 - AI 로봇 반려견이라는

훨씬 강한 관계를 만들어 낼 것 같아요.

로봇 반려견에 들어있는 AI와 몇년 동안 대화하고,

그러면서 이 AI 반려견은 나의 말투와 행동과 습관을 학습하고,

그에 맞춰서 나와 더 친근한 관계가 되고,

이 반려견이 언젠가 고장이 나서 폐기를 해야 하는 날이 온다면

우리는 눈물을 흘리겠죠? 로봇 반려견 부품을 화장하는 장례식도 하겠죠?

인간은 원래 감정이입을 잘 하니까요.

제자리에 박혀서 정확하게 프로그래밍 된 대로만 움직이던 산업용 6축 로봇의 시대가 가는군요.

GPT-4o의 기능만 덧붙여도

산업용 로봇이 이제 주변 상황 파악을 하고 (눈, 코, 입, 귀, 피부의 역할)

판단과 의사결정을 하고 (두뇌의 역할)

스스로 행동을 실행하겠죠 (근육의 역할, 이건 원래 로봇이 잘 하던거죠)

원래 이 정도 자율 행동 로봇을 만들려면

엄청난 데이터를 만들고 정리하고 학습시켜야 했는데요.

이제 곧 오픈AI 같은 대기업에서 만든 GPT-4o 같은 상용화된 AI를 탑재하고

파인튜닝만 조금 시키면 되는 세상이 오겠네요.

로봇을 만드는 수많은 벤처기업도 안전하지 않습니다.

SW를 오픈AI에 내줘버리면, 잘 나가는 로봇 벤처기업이,

어느 날 갑자기 단순 조립 업체가 돼 버릴 수도 있으니까요.

그래서 말입니다.

혹시나 아직 안 보셨다면 이 두 곳은 꼭 가보세요.

.jpg&blockId=18f88edc-d1fd-81bd-ab56-f1522ff9dee7)